这个工作流程的作用

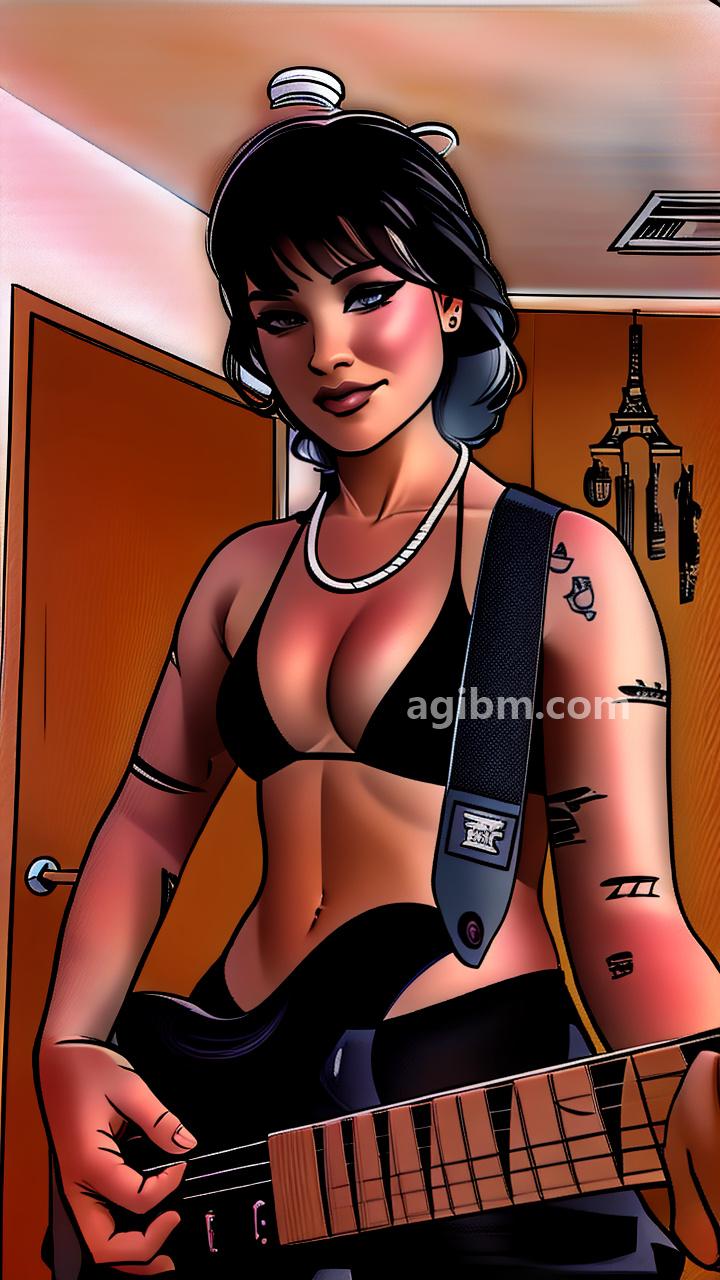

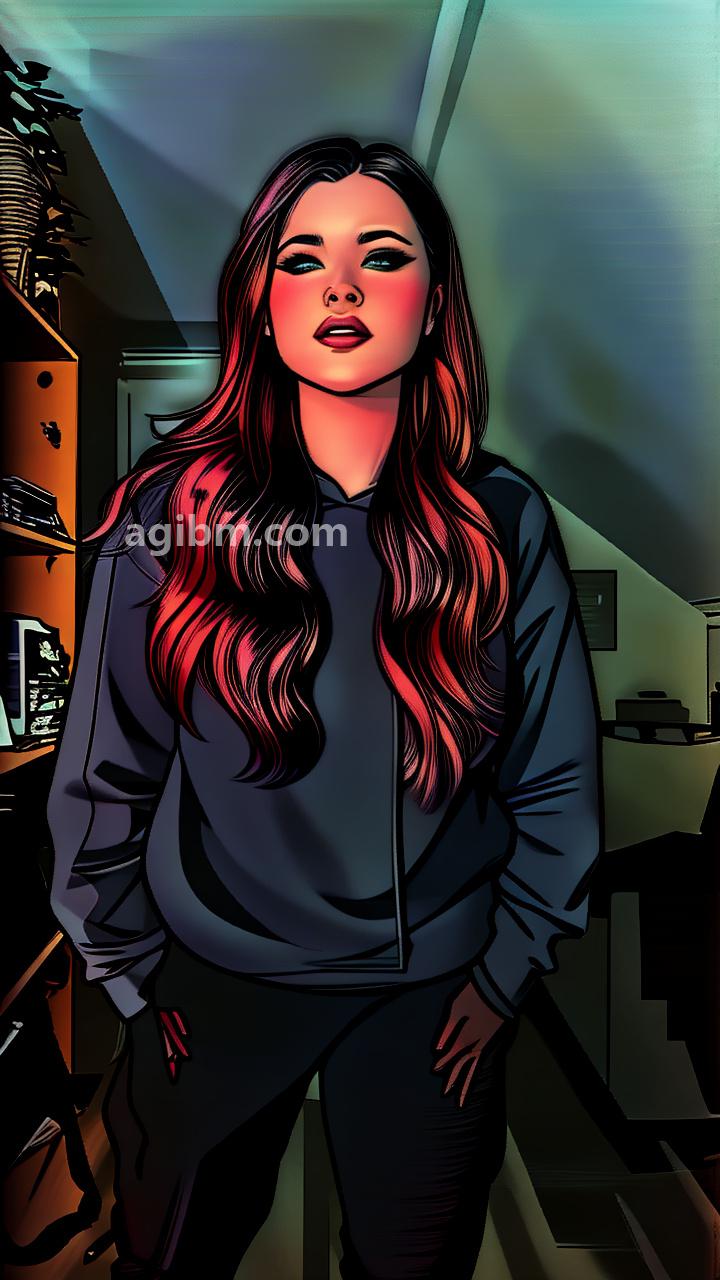

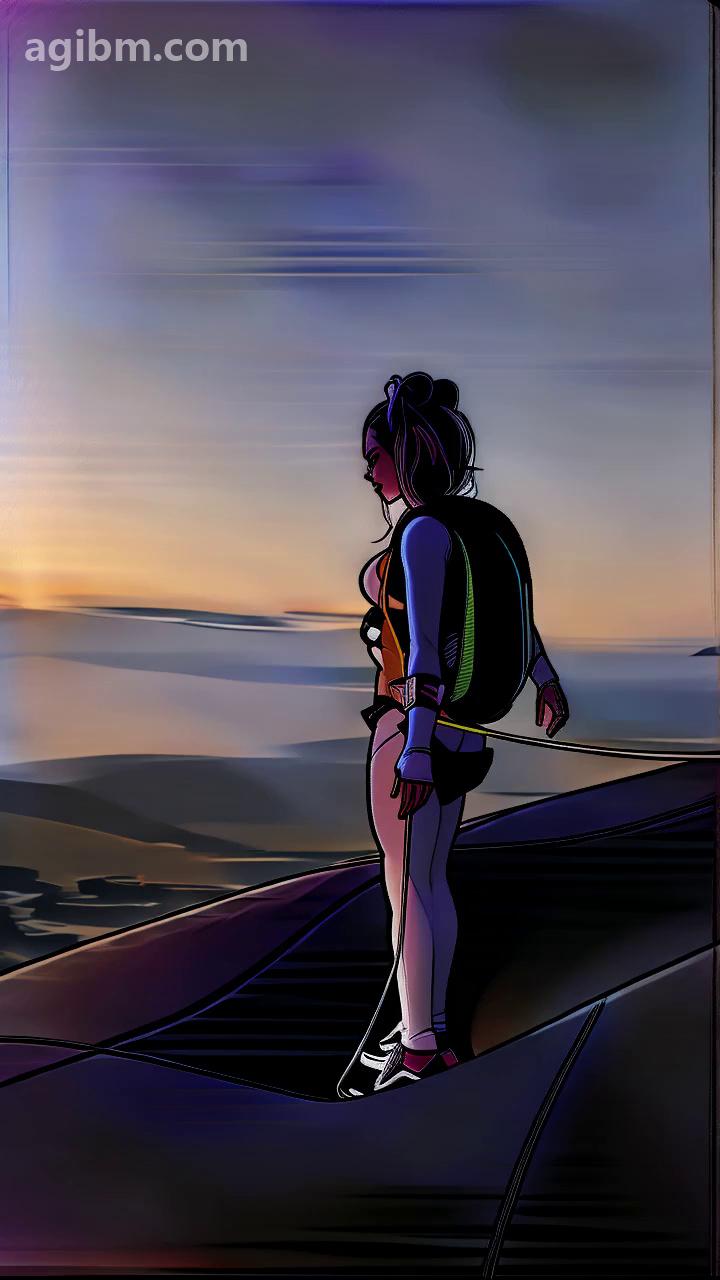

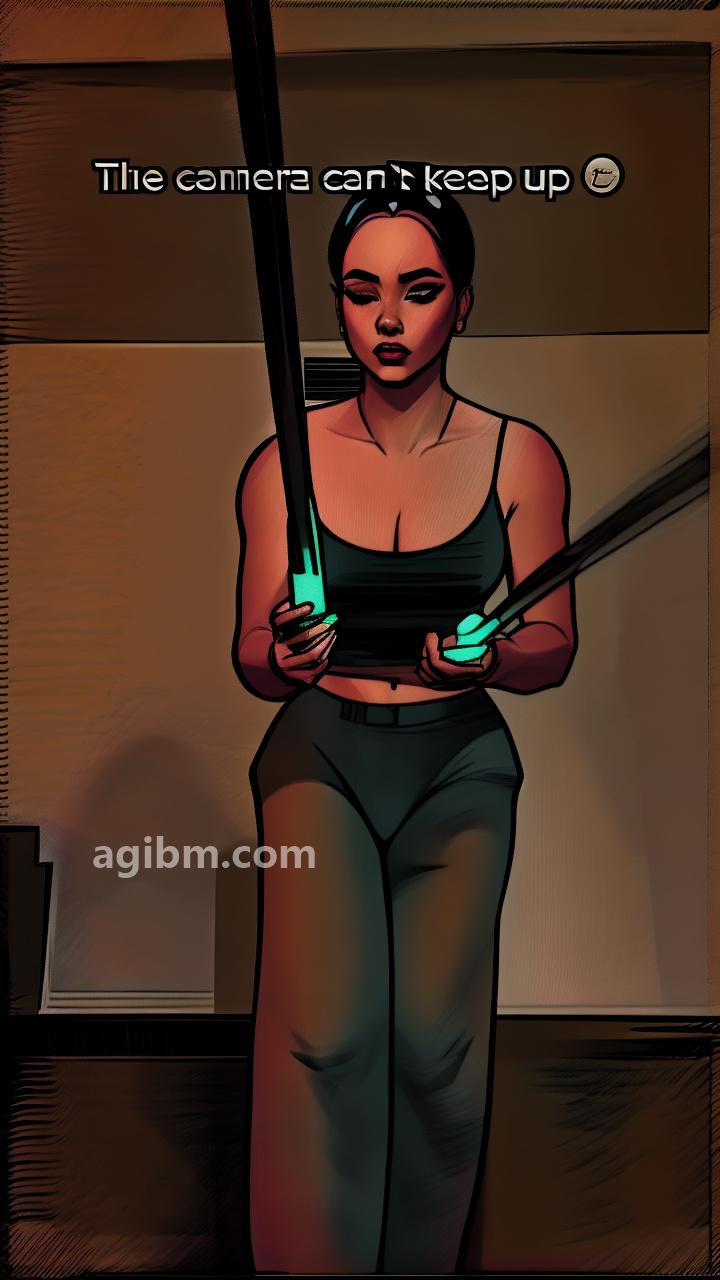

👉将任何视频变成了受GTA5 Artwork和Archer启发的漫画风格。使用Thicc线。

我发现的主要“技巧”对于这种特定风格来说确实很有效,就是使用comfies正常的图像操纵节点,尤其是混合和锐化。在将框架发送到AI样品之前,我将

1)融合到ControlNet动漫的输出,应用于正常视频框架,并将

2)应用于真实的lineart liniast the eart preprocessor的输出,以

反转图像。

这给出了整个视频的白色背景“草图”上的黑色线条。虽然由于动漫的线性预处理程序的工作方式,细节的素描较少,但字符/突出对象的轮廓更强。

i然后,我再次将每个帧的素描版本与原始视频,twic,twic,twic,twic,twic,twic,e(因为如果我只能这样做,因为草图中的所有白色,图片就会变得相当明亮)。这基本上导致了普通帧的旋转版本。

然后,我将此“预处理”图片发送给AI采样器。 Since the input now already contains “comic lines” to begin with, the AI manages to pull off quite nice results with some caveats:

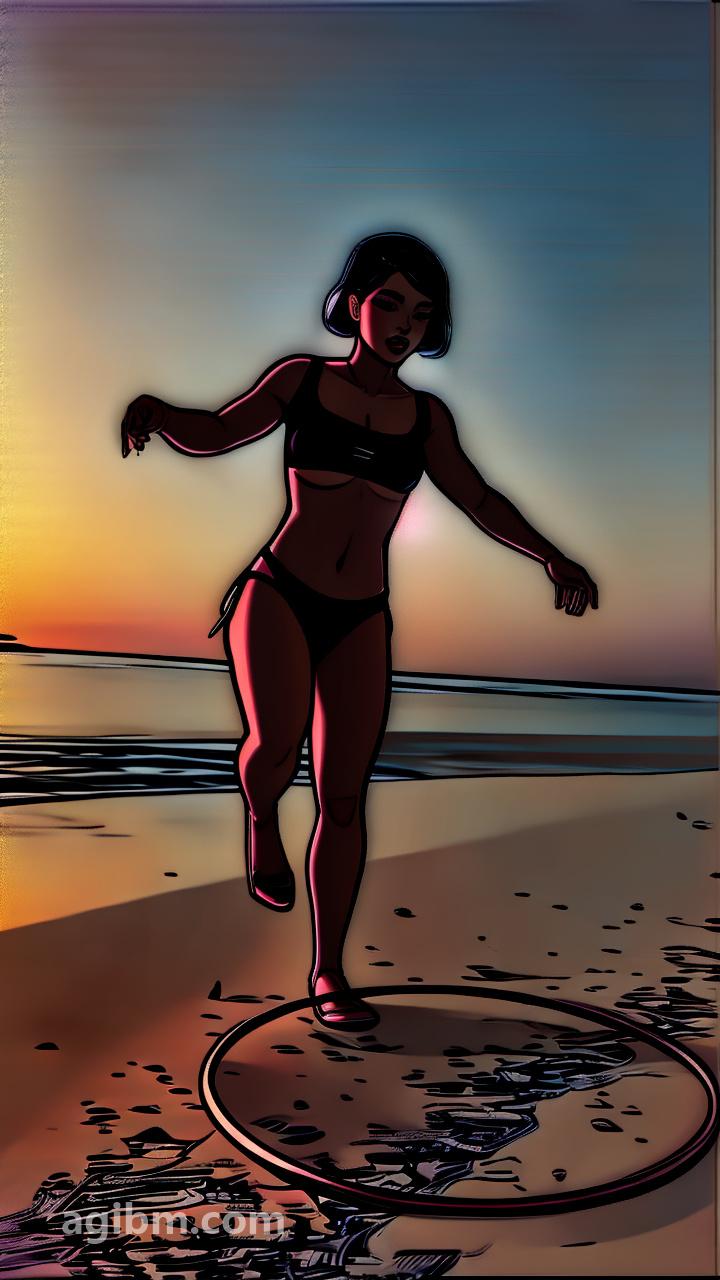

-Backgrounds are meh

-Far away characters are meh or terrible

These are the two main problems reamaining with the workflow, allthough I haven’t tried some post processing诸如Adetailer之类的方法。

如何使用此Workflow

👉选择输入视频,将框架分隔线(每个n帧)设置为分辨率(每个n帧)和分辨率,并且在输出中,根据您的分隔线设置帧率。

有关此工作流程的提示

👉用漫画模型测试:https://civitai.com/models/20294?modelversionid = 24129

用于不同样式的颜色压缩的Nable

👉具有正常的vae解码和瓷砖vae在工作流程中解释。瓷砖在上传版本中断开。如果您在VAE解码上用完了VRAM,则只需将瓷砖的VAE解码连接到(绕过的)量化节点,然后将您的瓷砖大小设置为硬件可以处理的任何东西(需要更长的时间,但节省了VRAM)。

👉取决于硬件和视频长度,在各种锐化/混合甚至视频保存步骤中,您可能会用尽正常的RAM(对我而言,这对我的剪辑就会发生长于25秒)。在舒适给您出现记忆错误之后,您可以再次排队(如果您没有在两者之间进行任何更改),并且它将恢复其关闭的位置并通常成功(除非您随着剪辑长度或分辨率而陷入困境)。正常的RAM管理似乎比舒适的VRAM管理要差,因此当我将其延长时,这种情况经常发生。

🎥视频演示链接(OPTional)

👉https://www.reddit.com/r/stablediffusion/comments/18w64yu/workflow_showcase_thicc_lines_comic_comic_style_yt/

👉 https://www.reddit.com/r/stablediffusion/comments/1906rd2/workflow_showcase_thicc_lines_comic_comic_style_2_more/